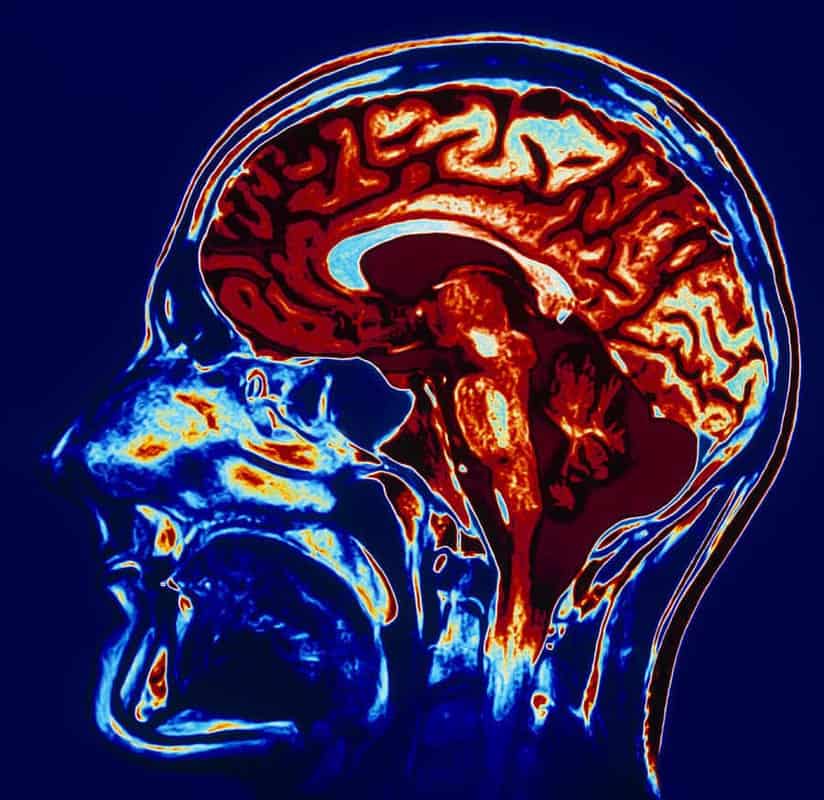

En las últimas décadas hemos visto una explosión de investigaciones basadas en imágenes cerebrales. Probablemente el método más conocido de investigación sea el fMRI (siglas en inglés de Imágenes por Resonancia Magnética funcional), que nos da imágenes como la que ilustra este artículo, que vemos tan a menudo en las noticias especializadas.

Este tipo de datos se utilizan con fines clínicos (por ejemplo, para planificar una cirugía), pero mayormente se han utilizado con fines de investigación. La metodología más frecuente es la de poner a una persona en un escáner como ese mientras se realiza una actividad (por ejemplo, tocar un instrumento musical). Lo que se hace entonces es escanear el cerebro en reposo para establecer una línea de base y luego se vuelve a escanear mientras la persona realiza la actividad, para detectar correlaciones entre la actividad y las zonas del cerebro que incrementan su activación al llevarla a cabo.

¿fMcómo?

Ahora bien, lo que es menos conocido es cómo se obtienen estas imágenes. Lo que mide un aparato de fMRI no es precisamente la actividad cerebral, sino el consumo de oxígeno en partes del cerebro. Se asume que si una zona en el cerebro está consumiendo más oxígeno durante la actividad (mientras se ejecuta el instrumento, en nuestro ejemplo), eso indica un incremento de la activación, y la palabra operativa aquí es “incremento”, y no “encendido”. En palabras de Satel y Lilienfeld (2013): “todo el cerebro viviente está siempre encendido; la sangre está siempre circulando y el oxígeno siempre está siendo consumido. El único cerebro realmente silencioso es el cerebro muerto”. Es decir, no se trata meramente de diferenciar una zona activa de una inactiva, sino de detectar incrementos de activación.

Para esto, el fMRI segmenta el cerebro en cubos de unos tres milímetros cúbicos llamados “voxels” (palabra derivada de volumen + pixel), y mide qué tanto se incrementó el nivel de activación -según el consumo de oxígeno- para cada uno de esos voxels, de los cuales hay unos 50000 en un escaneo normal. Los datos crudos del consumo de oxígeno son entonces analizados por una computadora para generar esas imágenes que vemos tan a menudo. En ellas los distintos colores representan la fuerza de activación de cada voxel entre el cerebro en reposo y el cerebro durante la actividad, para mostrar una representación gráfica de la activación cerebral.

En resumen: sí, es complicadísimo. No, no hay nada que se “ilumine” en el cerebro durante un fMRI.

Las críticas

El fMRI es una herramienta de un enorme potencial, que ha cambiado el panorama de investigación en neurociencias dramáticamente en las últimas décadas, pero no está exento de críticas. Una buena parte de las críticas (pero no todas), tiene que ver con los cálculos estadísticos necesarios para obtener los resultados. Para interpretar los datos crudos que genera la máquina de fMRI se utilizan distintos softwares y algoritmos con el fin de determinar si una zona cerebral específica se ha activado o no, es decir, si ha aumentado su activación de manera significativa. Un voxel podría aumentar su consumo de oxígeno por puro azar, sin que esté vinculado con la tarea realizada. La cuestión es que no es tan simple como observar el escaneo y decir “sí, se activó tal zona”, es necesaria una serie de operaciones para poder discernir eso.

El problema es que los cálculos estadísticos son tantos y tan complejos que pueden surgir errores: falsos positivos (una zona aparece activada cuando no lo está), y falsos negativos (no aparece activada cuando lo está). Un cierto porcentaje de falsos positivos y falsos negativos es esperable, pero si superan cierto umbral la información deja de ser fiable.

Una investigación hace algunos años, por ejemplo, demostró que si se usaban cálculos estadísticos erróneos, hasta el cerebro de un salmón muerto podía aparecer activándose en el fMRI.

El punto a recordar es que las imágenes de fMRI no son “fotos” del cerebro, sino más bien representaciones computarizadas en base a cálculos estadísticos hechos por software que indican la probabilidad de que una zona determinada se haya activado.

La investigación

Ahora bien, aquí llegamos a lo que queríamos contarles hoy. En un artículo publicado recientemente en el prestigioso journal PNAS (Proceedings of the National Academy of Sciences), se ofrecen resultados preocupantes: los paquetes de software que se utilizan más comúnmente para el análisis de datos fMRI pueden generar hasta un 70% de falsos positivos (Eklund, Nichols, & Knutsson, 2016).Para hacer esto, no usaron datos nuevos sino que utilizaron datos publicados de otras investigaciones (hay repositorios de datos científicos que se pueden re-analizar, por si les interesa hacer una investigación barata), y analizaron estos datos con los paquetes de software fMRI más comunes para ver qué tasa de falsos positivos se generaban sólo mediante el análisis de datos.

Como dijimos antes, el análisis de datos puede sugerir que una zona estaba activada cuando en realidad no lo estaba. Un porcentaje de esto es normal y esperable, y los autores esperaban una tasa del 5% de falsos positivos, de manera que obtener un 70% hace que uno empiece a desconfiar de los datos. La cosa es aún más seria porque no se trata de un error aislado, sino que los softwares más populares generan sistemáticamente falsos positivos. Este hallazgo es enorme, porque afectaría a casi todos los estudios de neuroimágenes que conocemos. Casi todas esas imágenes que muestran diarios y televisión podrían ser falsos positivos.

Como en Psyciencia cultivamos una mezcla de curiosidad y descaro, nos contactamos con su autor principal, Anders Eklund, para pedirle que nos hablara un poco sobre su investigación. Anders gentilmente accedió y esto es lo que les traemos a continuación.

– (F.M.)¿Podrías contarnos un poco acerca de tu formación académica e investigación actual?

–(A.E.) Completé una maestría en ingeniería eléctrica (procesamiento de imágenes), en 2007, y realicé mi doctorado entre 2008 y 2012 (ambos en la Linköping University, Suecia). Durante mi doctorado, me enfoqué en el procesamiento de imágenes médicas para imágenes por resonancia magnética funcional (fMRI, cómo estudiar la actividad cerebral utilizando escáneres de resonancia magnética), y también me interesé en estadística. Durante 2012-2014 hice un posdoctorado en Virginia Tech en Estados Unidos, donde continué trabajando con fMRI pero desde una perspectiva más aplicada (neurociencia, psicología). En 2014 me mudé nuevamente a Suecia para hacer un segundo posdoctorado, más enfocado en estadísticas. Hoy trabajo como profesor asistente en la Linköping University, principalmente desarrollando procesamiento de imágenes y algoritmos estadísticos para fMRI

–Leímos tu artículo Cluster failure: Why fMRI inferences for spatial extent have inflated false-positive rates, y nos pareció muy interesante ¿Qué estabas tratando de lograr con esa investigación?

–Quería investigar si los paquetes de software más comunes para fMRI (el SPM, FSL, AFNI), funcionan como deberían funcionar. Estos softwares utilizan una cierta cantidad de algoritmos estadísticos que dependen de un número de supuestos, pero nunca nadie ha investigado realmente si estos supuestos son verdaderos. Hoy es posible descargar libremente datos disponibles de fMRI de varios centenares de sujetos, cosa que aprovechamos para testear esos métodos –hubiera sido muy costoso y engorroso recolectar todos esos datos.

–Nos sorprendió bastante esta frase en el artículo “en teoría, deberíamos encontrar un 5% de falsos positivos (…), pero en su lugar encontramos que los paquetes de software para análisis de fMRI (…) pueden resultar en tasas de falsos positivos de hasta un 70%”. ¿Qué significa esto?

–Significa, por ejemplo, que los softwares pueden decirle al usuario que hay una diferencia significativa entre dos grupos de sujetos (por ejemplo, entre personas sanas y personas con alguna enfermedad), cuando en realidad no hay diferencia.

Para llegar a esta conclusión llevamos a cabo muchas comparaciones aleatorias entre grupos utilizando sólo personas sanas, y simplemente contamos cuántas veces descubrimos una diferencia significativa entre los grupos (cuando en realidad no hay tal diferencia, dado que todos los sujetos eran personas sanas). Si los softwares funcionaran correctamente, deberíamos encontrar diferencias en sólo 5% de los análisis (por azar), pero las encontramos con mucha más frecuencia.

–El artículo dice que los resultados “ponen en cuestión la validez de alrededor de 40000 estudios con fMRI”. ¿Podrías expandir esto? ¿Cuáles son las implicaciones para las investigaciones pasadas y para el uso de fMRI en diagnóstico?

–Desde sus inicios alrededor de 1992, la fMRI ha sido usada para alrededor de 40.000 estudios sobre el cerebro humano. La mayoría de estos estudios confían en métodos estadísticos de los cuales se ha demostrado que dan resultados erróneos, pero es imposible saber cuántos de estos estudios son realmente erróneos (mayormente porque los datos no están disponibles para reanalizarlos). Para las investigaciones futuras, los investigadores deberían ser más cuidados con los métodos estadísticos que utilizan.

–A la luz de esta investigación, ¿qué querrías que pasara en tu campo?

Me gustaría que los investigadores utilizaran otros métodos estadísticos, que estén basados en menos supuestos. En el artículo, demostramos que tales métodos dan resultados mucho mejores. Una desventaja de esos métodos es que lleva más tiempo analizar los datos, pero hoy tenemos computadoras mucho más rápidas que hace 10 años atrás.

–¡Gracias por tu tiempo!

El tema es complicado, pero enormemente interesante. Sería un error pretender descartar todos los estudios basados en fMRI por hallazgos como este. Creo que el punto a llevar a casa es que la ciencia es más sutil que lo que presentan los titulares de los diarios, incluso el titular que le estamos poniendo a este artículo –por eso es una buena política no quedarse con el titular al ver una noticia de ciencia.

Las neuroimágenes se están usando para todo tipo de prometedoras investigaciones en ciencia básica y aplicada, y hallazgos como el de Eklund y colaboradores pueden servir para mejorar los análisis y estar más al tanto de las limitaciones de esta metodología.

Así que piensen, sean escépticos, sean curiosos. Nos leemos la próxima.

Referencias

Eklund, A., Nichols, T. E., & Knutsson, H. (2016). Cluster failure: Why fMRI inferences for spatial extent have inflated false-positive rates. Proceedings of the National Academy of Sciences, 201602413. http://doi.org/10.1073/pnas.1602413113

Satel, S., & Lilienfeld, S. O. (2013). Brainwashed. New York: Basic Books.

Imagen: Science Photo Library